TV 4K e HDR: tutto quello che c’è da sapere

Facciamo il punto sulle reali potenzialità di un formato ormai diffuso, ma che genera ancora numerose incomprensioni

La generazione dei televisori 4k è ormai entrata nel vivo ed il passaggio a questo formato è diventato ormai accessibile in termini di prezzi ed assortimento. L’annuncio della nuova generazione videoludica ha messo ulteriori pressioni sui giocatori su console, ma anche l’utenza dei principali servizi di streaming non può rimanere impassibile dinanzi ad una crescita considerevole dei contenuti UltraHD. Molti di voi saranno in quindi in proncinto di rottamare il vecchio schermo FullHD, o magari uno dei primi modelli di TV 4k.

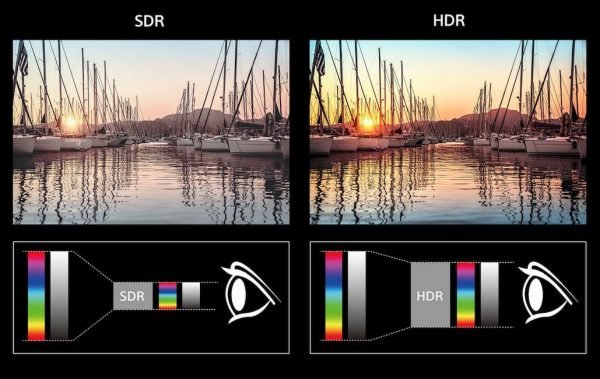

Dopo aver conseguito un dettaglio ad altissima risoluzione, è stato necessario un salto tecnologico mirato al miglioramento dell’immagine in movimento, in termini di contrasto e spinta cromatica. Una svolta che è arrivata da alcuni anni con la tecnologia HDR. Nonostante non si tratti più di una rivoluzione ma di una concreta realtà, l’impressione è che non sia stata ancora del tutto assimilata dall’utenza media. Cerchiamo quindi di fare chiarezza, analizzando alcuni aspetti che hanno destato ben più di un fraintendimento, nell’intento di capire come l’HDR possa realmente migliorare l’esperienza dello spettatore.

Notte buia, tante stelle

Un segnale video ad elevata gamma dinamica, o HDR (High Dynamic Range), agisce in primis sul contrasto d’immagine, allo scopo di incrementare la differenza tra zone di luce e di oscurità. Semplificando ulteriormente, l’obiettivo principale dell’HDR è quello di fornire bianchi più brillanti e neri più scuri, saturi ed uniformi.

Per comprendere meglio l’importanza del contrasto d’immagine nelle zone più scure, basti pensare all’effetto visivo di uno spettacolo pirotecnico. Quale esperienza offrirebbero i fuochi artificiali in pieno giorno? Oppure alla percezione dell’occhio umano quando si osserva il cielo notturno. Quanto cambia la vista del firmamento in una zona di campagna, rispetto ad un’area metropolitana? Nel primo caso, il nostro occhio percepisce molti più dettagli di un oggetto luminoso, soprattuto nei contorni. Questo avviene quando la visione complessiva non è falsata da altre fonti di luce. Tuttavia, se riprendiamo il cielo con una tradizionale videocamera il risultato è ben diverso. L’HDR ha l’intento di valicare questo limite e portare su schermo un’esperienza simile a quella percepita dai sensori dell’occhio umano.

Non finisce qui: una fonte video HDR fornisce un range cromatico a 10 bit, ovvero dell’ordine del miliardo di tonalità diverse, in grado di ricoprire tra il 54% ed il 76% dei colori presenti in natura. Un bel salto in avanti rispetto allo standard Blu-Ray che garantisce tonalità a 8 bit, ovvero 16 milioni di colori e 35% di copertura. Il risultato complessivo trasmette una visione intensa, vibrante e mai sperimentata in precedenza.

Possiamo quindi affermare che l’HDR non è oggetto delle solite strategie di marketing?Non del tutto, purtroppo. Come già detto in precedenza, questa tecnologia non è stata ancora del tutto compresa e l’utente medio, anche per questioni di budget, è costantemente alla ricerca del best buy o del prodotto superscontato, senza soffermarsi sul vero significato del bollino “HDR” stampato sulla confezione. Bollino che rappresenta, a mio avviso, il primo grosso equivoco.

Non è tutto HDR quel che luccica

Innanzitutto per usufruire di una visione in HDR è necessario disporre di un segnale video apposito, erogato da un supporto fisico o un servizio di broadcasting.

Un TV 4K HDR-compatibile è semplicemente un dispositivo in grado di riprodurre questo tipo di segnale. Tutto qui. Il discorso cambia radicalmente quando si parla di come un pannello gestisca le sequenze ad elevata gamma dinamica. Se la risoluzione a 4k è la stessa per qualsiasi TV di questa generazione, non si può dire altrettanto del modo di fruire dei contenuti HDR, le cui potenzialità in certi casi possono risultare quasi impercettibili, nonostante la certificazione. Il vero punto cardine per la visione di un video in HDR è dato da uno specifico parametro legato alla luminosità dello schermo. E, ovviamente, non è lo stesso per tutti gli apparecchi televisivi.

Entriamo nel dettaglio (ma non troppo) introducendo una grandezza fisica denominata Luminanza, che misura l’intensità luminosa di una superficie che riflette la luce. Il suo valore, su scala vettoriale, rappresenta il rapporto tra luce emessa (candela – cd) ed area della superficie emittente (metro quadro – q). La sua unità di misura è il nit, ovvero cd/mq. Ma non scendiamo in particolari troppo tecnici: all’utente basti sapere che, in termini qualitativi, uno schermo deve ambire ad un picco di luminosità più alto possibile a fronte di un picco di neri più basso. Il rapporto tra i due indica infatti il cosiddetto rapporto di contrasto. Questo spiegherebbe, tra l’altro, il teorico “contrasto infinito” dei pannelli OLED, in cui i led in presenza di neri si spengono portando al denominatore un valore pari a 0.

Per quanto riguarda le specifiche, un TV HDR-compatibile deve sostanzialmente garantire il supporto a flussi video che trasportano informazioni secondo lo standard aperto HDR10, che garantisce 10 bit di tonalità cromatica e una luminosità di picco di 4000 nit. Quest’ultimo rappresenta un valore puramente teorico, dato che i TV odierni sono ben lontani da quella cifra, anche se sono già stati annunciati TV in grado di raggiungerla. Si tratta comunque di prodotti di fascia alta (molto alta) e di prossima generazione (8k) che verranno messi sul mercato a prezzi difficillmente inferiori ai 5000 euro.

E allora quale sarebbe il valore di picco di luminosità ottimale per un TV odierno?

Una prima indicazione ci viene fornita da UHD Alliance, un consorzio che comprende numerose major hi-tech e case di produzione video che ha definito negli ultimi anni le specifiche del marchio UHD Premium. Per ottenere l’ennesimo bollino, un televisore 4k HDR deve soddisfare uno dei seguenti intervalli di luminosità:

– 1000 nit di picco di luminosità e 0.05 nit di livello di nero

– 540 nit di picco di luminosità e 0,0005 di livello di nero

Il marchio UHD Premium, anche se puramente indicativo, rappresenta sicuramente un primo passo da considerare prima di acquistare un televisore UltraHD, anche perchè non sempre il rapporto di contrasto è presente tra le specifiche tecniche di un prodotto.

Lo schermo farà la differenza

Andando a leggere alcune recensioni dell’anno passato relative ai modelli best buy di fascia compresa tra i 500-600 euro su alcuni autorevoli siti specializzati, si noterà spesso che, al di là dei numerosi pregi contestualizzati al prezzo, viene indicato come difetto principale la riproduzione dei contenuti in HDR. Gli esperti lasciano intendere che in certi casi l’HDR sia un optional e niente di più. Questi modelli, non a caso, mostrano un picco di luminosità prossimo ai 300 nit, valore ottimale per flussi video del formato standard (SDR – Standard Dynamic Range).

Personalmente ritengo che un prodotto dal picco di luminosità al di sotto della soglia UHD Premium (540 nit) possa limitare sensibilmente l’esperienza di un contenuto HDR. Il rischio è quello di spendere una somma, comunque non indifferente, per un dispositivo che potrebbe arginare una tecnologia cardine che, come menzionato nell’introduzione, è già realtà, ma che ha ancora tanto da dimostrare. Anche in ambito videludico. Abbiamo già avuto ampie dimostrazioni (e qualche fregatura) in questo periodo di fine generazione ed è auspicabile pensare che l’HDR possa fare la differenza nella prossima. Ai fini dell’immersività gli sviluppatori punteranno sicuramente sull’HDR per mettere in risalto colori, luci e contrasti. Affidarsi soltanto a risoluzione e frame-rate potrebbe risultare nell’immediato futuro una pratica limitante e la scelta dello schermo è destinata, più che in passato, a cambiare le carte in tavola.

Ho avuto la possibilità di veder girare God of War su Ps4 Pro e TV 4K HDR superbudget e, successivamente, su Ps4 “liscia” e TV di fascia media con HDR regolato ad hoc. Nonostante la differenza di risoluzione, la seconda configurazione è risultata decisamente più coinvolgente e convincente, trasmettendo una vera e propria “esplosione” del comparto artistico.

Questioni di budget

Il primo consiglio prima di acquistare un TV di questa generazione è, ovviamente, quello di andare a valutare con i propri occhi. Può sembrare banale, ma per molti non è più una pratica così comune, specialmente se troppo assuefatti dal mercato online e le sue seducenti megaofferte a tempo limitato.

Nei centri commerciali la situazione non è sicuramente ottimale a causa dell’eccessiva luminosità dell’ambiente o una calibrazione essenziale degli schermi, ma è comunque sufficiente per fare alcune considerazioni. Solo in un secondo momento può avere senso la documentazione online. Se il termine di paragone è il FullHD 1080p, ovviamente, anche un prodotto entry-level può garantire un “effetto wow”. Ma è su un TV di fascia media che si può probabilmente ammirare il lavoro sui contrasti e probabilmente una riduzione di quella patina “grigionebbia” che appiattisce la visione. Tanto meglio se è stato posizionato nei pressi di un TV di fascia bassa (anche top di gamma).

Al di là di una maggior qualità della componentistica, la fascia media può contare su ulteriori implementazioni orientate alla rifinitura delle immagini in movimento. La più interessante è probabilmente il local dimming, un sistema in grado di modulare la luce nelle varie zone dello schermo in base alla luminosità, agendo direttamente sul rapporto di contrasto e favorendo quindi i contenuti HDR.

Partiamo da un budget adeguato ad un apprezzabile TV entry-level, ovvero 500 euro, al di sotto del quale non c’è poi molto da ragionare. Il consiglio è quello di aumentare, se possibile, la somma preventivata di 200-300 euro. Può essere già un investimento sufficiente per effettuare il salto di qualità. La fascia media si attesta solitamente tra i 1000 ed i 1500 euro, ma in alcuni periodi dell’anno possono arrivare dei sensibili tagli di prezzo, che offrono la possibilità di portarsi a casa un valido TV HDR al prezzo di un seppur meritevole entry-level top di gamma. Ed anche in questo caso le differenze qualitative restano degne di rilievo. Solitamente i nuovi modelli vengono messi sul mercato ad aprile, qualche mese dopo la presentazione al CES di Las Vegas, ma i primi sconti possono arrivare già ad estate inoltrata. Spesso è possibile anche puntare su un TV dell’anno precedente, anche se tendenzialmente i vecchi modelli vengono ritirati dal mercato.

La guerra degli standard

L’ultima questione riguarda la differenza tra i vari formati HDR. Come già detto in precedenza le basi di partenza sono le specifiche dell’HDR10 che costituiscono la certificazione. Ma l’attenzione adesso è già rivolta alle nuove implementazioni. Anche in questo caso, la mancanza di uno standard de-facto ha contribuito a generare incomprensioni.

Per le trasmissioni televisive è stato introdotto l’HLG, ovvero Hybrid Log Gamma, sviluppato dall’emittente inglese BBC. Il termine parla chiaro: si tratta di un segnale nato dalla combinazione del segnale video HDR ed SDR. Lo scopo è quello di garantire la compatibilità con i vecchi apparecchi TV, dove il segnale viene riprodotto in gamma dinamica standard.

Per quanto riguarda i supporti fisici ed i servizi di streaming i formati in corsa sono due: Dolby Vision e HDR10+.

Lato streaming, Netflix sembra maggiormente interessata ad inserire contenuti Dolby Vision, mentre Amazon Prime Video ha fornito maggior supporto per l’HDR10+. Ma in futuro i servizi li dovrebbero supportare entrambi.

Dolby Vision è una tecnologia proprietaria che estende la tonalità cromatica a 12 bit e il picco di luminosità a 10000 nit. Per raggiungere questo valore dovremo probabilmente aspettare la tecnologia MicroLed, che ha buone chance di surclassare gli attuali modelli Qled e Oled. Dolby Vision ha inoltre introdotto l’inedito concetto di flusso di metadati dinamici, allo scopo di ottimizzare le performance fotogramma per fotogramma.

HDR10+ è invece un’estensione open source del formato HDR10, che può contare sul supporto da parte di Samsung. E’ uno standard che non si discosta molto dal suo predecessore ma, come il Dolby Vision, è in grado di gestire il flusso di metadati dinamici.

Sulla carta il Dolby Vision dovrebbe garantire una resa maggiore rispetto al rivale, anche se la differenza di prestazioni potrebbe essere rilevante solo nella prossima generazione. HDR10+ potrebbe però avere la meglio, grazie alla sua natura open source e la mancanza dei costi di licenza.

Ci sono 6 commenti

Lascia un commento

Devi essere connesso per inviare un commento.

Davvero un bell articolo!!!!

Grazie! Spero ti sia stato utile

Ottimo articolo Antonio anche io ho comprato da poco tv 4k HDR 49 pollici sui 900 euri grazie a questo articolo mi sono portato a casa un tv credo buono… grazie ah é un Sony

Bellissimo articolo molto esaustivo,per ora oh un Sony AF8 65,per qualche anno fino all’uscita a prezzi umani dei microled dovrei essere apposto

Grazie! Beh, più che a posto direi. Stiamo parlando di un eccellente prodotto di fascia alta. Se non sbaglio, deve avere anche un ottimo comparto audio

Devo correggermi chiedo scusa ho scritto che questo articolo l’ha scritto Antonio invece è di Iacopo Risi…. Scusatemi ancora